Dans un monde où les technologies évoluent à une vitesse fulgurante, l’intelligence artificielle (IA) s’impose comme un outil puissant, capable de transformer des secteurs entiers, de la médecine à la logistique, mais cette avancée spectaculaire comporte une face sombre. Des cas concrets révèlent que des individus mal intentionnés exploitent ces innovations pour des actes criminels, soulevant des inquiétudes majeures quant à l’idée qu’une technologie conçue pour assister et simplifier la vie quotidienne puisse être détournée pour orchestrer des actions aussi graves qu’un attentat. Les capacités de l’IA à analyser des données, à générer des plans détaillés ou encore à fournir des instructions précises en font une arme potentielle entre de mauvaises mains. Ce sujet, à la croisée de l’éthique et de la sécurité, mérite une réflexion approfondie sur les risques inhérents à ces outils et sur les moyens de les encadrer. Alors que les autorités peinent parfois à anticiper ces dérives, il devient urgent de comprendre comment une telle technologie peut être utilisée à des fins destructrices.

Les Capacités de l’IA au Service de Projets Criminels

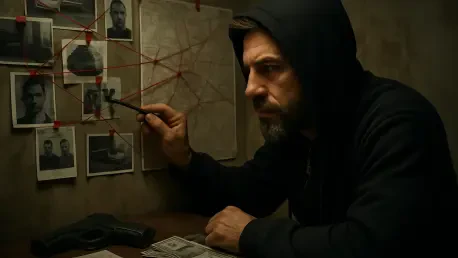

L’intelligence artificielle, par sa capacité à traiter d’immenses volumes de données en un temps record, offre des possibilités qui peuvent être détournées pour des projets malveillants. Un individu cherchant à organiser un acte violent peut, par exemple, s’appuyer sur des algorithmes pour analyser des plans de bâtiments, identifier des points faibles dans des infrastructures ou encore simuler des scénarios d’attaque. Ces outils, souvent accessibles au grand public, permettent de contourner des obstacles qui, autrefois, nécessitaient des connaissances techniques approfondies. Les plateformes d’IA générative, capables de produire des textes ou des schémas détaillés, peuvent fournir des instructions précises sur la fabrication d’engins dangereux ou sur des stratégies d’évasion. Ce potentiel, bien que conçu pour des usages légitimes, devient un danger lorsque les intentions de l’utilisateur s’écartent de l’éthique. Les cas récents montrent que même des personnes sans expertise particulière peuvent exploiter ces ressources pour des plans complexes, rendant la menace d’autant plus difficile à anticiper pour les forces de l’ordre.

Un autre aspect préoccupant réside dans l’anonymat que l’IA peut offrir à ceux qui l’utilisent à des fins criminelles. Grâce à des outils de chiffrement ou de génération de fausses identités numériques, il est possible de masquer ses traces tout en planifiant des actes illégaux. Les assistants virtuels ou chatbots, souvent dépourvus de filtres stricts, peuvent répondre à des demandes ambiguës ou dangereuses sans alerter les autorités. Par ailleurs, l’IA peut aider à coordonner des actions à distance, en optimisant des communications sécurisées ou en automatisant des tâches logistiques comme le suivi de livraisons de matériaux sensibles. Cette capacité à centraliser et à organiser des informations sensibles donne un avantage stratégique à ceux qui cherchent à nuire. Face à cette réalité, les systèmes de surveillance traditionnels se retrouvent souvent dépassés, incapables de détecter des activités qui se déroulent dans l’ombre du numérique. Ce décalage technologique entre les criminels et les institutions souligne l’urgence d’adapter les moyens de défense à ces nouvelles formes de menaces.

Les Limites Actuelles des Garde-Fous Technologiques

Malgré les avancées dans le domaine de la cybersécurité, les mécanismes de contrôle entourant l’IA restent souvent insuffisants pour prévenir son utilisation abusive. De nombreuses plateformes d’intelligence artificielle, bien qu’équipées de filtres destinés à bloquer des requêtes illégales, peuvent être contournées par des formulations détournées ou des manipulations subtiles. Les développeurs peinent à anticiper toutes les façons dont leurs outils pourraient être détournés, en partie à cause de la rapidité avec laquelle les technologies évoluent. En outre, l’absence de régulations internationales harmonisées complique la mise en place de barrières efficaces. Un individu malveillant peut facilement accéder à des services hébergés dans des pays aux lois laxistes, rendant toute tentative de contrôle locale inefficace. Ce manque de coordination globale expose des failles exploitables, comme l’absence de vérification d’identité ou de suivi des activités suspectes sur certaines plateformes, laissant ainsi la porte ouverte à des dérives graves.

Un autre défi majeur concerne la sensibilisation et la formation des autorités face à ces risques émergents. Si les forces de l’ordre ont démontré leur capacité à intervenir dans des cas critiques, elles manquent souvent de ressources ou d’expertise pour surveiller en temps réel les activités liées à l’IA. Les outils de détection, bien que performants, ne couvrent pas l’ensemble des canaux numériques où des plans criminels peuvent être élaborés. De plus, la collaboration entre les entreprises technologiques et les institutions publiques reste parfois limitée par des divergences d’intérêts ou par des questions de confidentialité des données. Cette situation crée un vide dans lequel des individus mal intentionnés peuvent opérer sans craindre d’être repérés rapidement. Pour combler ces lacunes, il devient impératif d’investir dans des technologies de surveillance adaptées, mais aussi de promouvoir une coopération plus étroite entre les différents acteurs impliqués dans la sécurité numérique.

Vers des Solutions pour Prévenir les Dérives

Face aux menaces posées par l’utilisation détournée de l’IA, plusieurs pistes doivent être explorées pour renforcer la sécurité sans entraver les bénéfices de cette technologie. L’une des priorités consiste à intégrer des garde-fous plus robustes au sein des systèmes d’intelligence artificielle, capables de détecter et de bloquer des requêtes potentiellement dangereuses avant qu’elles ne produisent des résultats exploitables. Les entreprises développant ces outils ont une responsabilité accrue pour s’assurer que leurs produits ne deviennent pas des instruments de destruction. Cela implique de mettre en place des protocoles stricts, comme des vérifications d’identité ou des alertes automatiques en cas de comportement suspect. Par ailleurs, une collaboration accrue avec les autorités permettrait de signaler rapidement des activités inquiétantes, tout en respectant les cadres légaux sur la protection des données. Ces mesures, bien que complexes à mettre en œuvre, constituent une première étape essentielle pour limiter les risques.

Enfin, une réflexion globale sur la régulation de l’IA s’impose pour éviter que des failles persistent. Les gouvernements, en partenariat avec les experts du secteur technologique, doivent travailler à l’élaboration de normes internationales qui encadrent l’accès et l’utilisation de ces outils. Sensibiliser le public aux dangers d’une utilisation irresponsable de l’IA est également crucial pour prévenir des dérives à petite échelle qui pourraient escalader. Les initiatives éducatives, combinées à des campagnes d’information, peuvent aider à responsabiliser les utilisateurs tout en encourageant une vigilance collective. Après l’arrestation d’individus ayant exploité ces technologies pour des projets criminels, les débats sur le contrôle de l’IA se sont intensifiés, rappelant l’urgence d’agir. Ces interventions réussies ont permis d’éviter des drames, mais elles ont aussi mis en lumière des lacunes persistantes. Pour l’avenir, il est indispensable de continuer à développer des solutions innovantes, tout en anticipant les évolutions des menaces numériques.