Loin des récits glorifiant la seule prouesse algorithmique, la révolution de l’intelligence artificielle est de plus en plus gouvernée par une loi bien plus terre à terre : celle des capitaux massifs, qui dicte désormais les règles du jeu et façonne les contours de l’innovation future. Cette course effrénée à la suprématie technologique se révèle être, avant toute chose, une compétition acharnée pour attirer des financements colossaux, transformant le secteur en une arène où seuls les acteurs les mieux dotés financièrement peuvent espérer survivre et prospérer. L’accès à des ressources quasi illimitées est devenu le principal carburant de la recherche, de l’acquisition des talents et, surtout, de la puissance de calcul indispensable pour entraîner les modèles les plus avancés. Cette dynamique impitoyable redéfinit la nature même de l’innovation, la rendant inextricablement liée à la capacité de mobiliser des milliards de dollars, reléguant parfois au second plan la pure brillance conceptuelle au profit de la force de frappe financière. Les stratégies des géants de l’industrie, qu’il s’agisse de manœuvres financières audacieuses ou de levées de fonds aux montants vertigineux, confirment cette tendance de fond où le capital n’est plus seulement un moyen, mais l’arbitre principal du succès.

Une Vision Philosophique au Cœur de la Stratégie

Jensen Huang, le charismatique PDG de Nvidia, apporte une perspective à la fois philosophique et pragmatique sur le développement de l’intelligence artificielle, qui, bien que nuancée, renforce l’idée de la nécessité d’un investissement massif et patient. Il se plaît à comparer l’intégration de l’IA au sein d’une entreprise à un processus organique, similaire à l’éducation d’un enfant ou à l’entretien d’un jardin. Cette métaphore illustre sa conviction qu’il faut résister à la tentation d’une recherche obsessionnelle et immédiate d’un retour sur investissement quantifiable pour chaque initiative. Au contraire, il préconise une phase d’expérimentation large et débridée, qu’il résume par l’expression « laisser un millier de fleurs s’épanouir » , avant de procéder à une sélection rigoureuse des projets les plus prometteurs. Une telle approche, qui valorise l’exploration et accepte l’échec comme partie intégrante du processus d’innovation, ne peut être soutenue que par un capital abondant et une vision à long terme, capables d’absorber les coûts de cette phase exploratoire sans exiger de rentabilité à court terme. C’est une vision qui contraste fortement avec les modèles économiques traditionnels axés sur l’efficacité et l’optimisation des ressources à chaque étape.

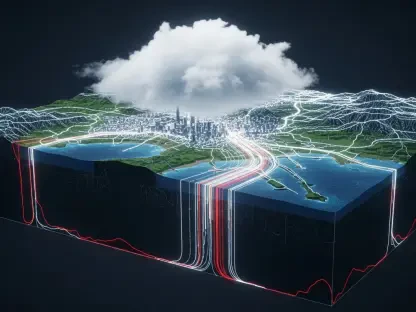

Face aux inquiétudes des marchés financiers concernant l’avenir des entreprises de logiciels, Jensen Huang se montre également rassurant, cherchant à démystifier la menace d’une cannibalisation par l’IA. Il compare les logiciels traditionnels à des outils fondamentaux comme les « calculatrices » , indispensables et qu’il n’est nullement nécessaire de réinventer. Dans sa perspective, les agents d’intelligence artificielle ne sont pas destinés à remplacer ces outils, mais plutôt à les utiliser de manière plus efficace et intelligente, agissant comme des opérateurs experts plutôt que comme des substituts. Cette vision d’une synergie, où l’IA augmente les capacités des logiciels existants, suggère une coexistence harmonieuse et une évolution de l’écosystème plutôt qu’une disruption destructrice. De manière plus inattendue, venant du dirigeant dont les principaux clients sont les géants du nuage, il exprime un certain scepticisme à l’égard d’une migration totale des données vers le cloud. Il insiste sur l’enjeu crucial de la souveraineté et de la sécurité des données, affirmant qu’il ne confierait jamais les informations les plus sensibles de son entreprise à des services externes. Cette prise de position forte suggère que de nombreuses organisations opteront pour des solutions d’IA locales (« on-premise » ) pour protéger leur patrimoine informationnel, ouvrant ainsi un vaste marché pour des infrastructures hybrides et sécurisées.

Les Méga-Transactions Comme Preuve par les Chiffres

La primauté du capital dans la course à l’IA est démontrée de manière spectaculaire par les récentes manœuvres financières qui secouent l’industrie. La consolidation de xAI, l’entreprise d’IA d’Elon Musk, avec son fleuron aérospatial SpaceX, est une illustration parfaite de cette logique. L’objectif principal de cette opération n’est pas tant de créer une synergie technologique évidente entre la conquête spatiale et l’intelligence artificielle, mais bien de répondre à un impératif financier pressant. En regroupant les deux entités, la manœuvre vise à capitaliser sur l’immense attrait des investisseurs pour Starlink, la branche la plus lucrative de SpaceX, afin de faciliter la levée des fonds colossaux nécessaires au développement de xAI, une entité extrêmement gourmande en liquidités. Cette stratégie consiste à adosser un projet à très haut risque et à forte consommation de capital à un actif déjà rentable et solidement établi, prouvant que la sécurisation du financement peut primer sur la cohérence industrielle à court terme. Bien que cette approche suscite des interrogations chez certains investisseurs de SpaceX, elle est largement acceptée comme une composante du « risque Musk » , où les ambitions démesurées sont financées par des montages audacieux.

Dans la même veine, le tour de financement actuellement mené par OpenAI pousse cette dynamique à une échelle sans précédent, avec des valorisations et des levées de fonds qui atteignent des sommets vertigineux, dépassant parfois les prévisions les plus optimistes. Les chiffres évoqués, avec des investissements de plusieurs dizaines de milliards de dollars de la part de partenaires stratégiques comme Amazon, Nvidia et SoftBank, ne témoignent pas seulement d’une confiance aveugle dans la technologie, mais aussi de la mise en place de dépendances stratégiques complexes et calculées. Pour Nvidia, par exemple, investir massivement dans OpenAI est une manœuvre défensive autant qu’offensive : il s’agit de fidéliser l’un de ses plus grands clients et de s’assurer une place de choix dans l’écosystème naissant. Cependant, cette relation symbiotique est déjà en pleine évolution. Conscient des risques liés à une dépendance excessive envers un unique fournisseur de matériel, OpenAI chercherait activement des alternatives aux puces de Nvidia, notamment pour les tâches d’inférence qui exigent des temps de réponse ultra-rapides. Cette situation illustre parfaitement comment les flux de capitaux, tout en créant des alliances puissantes, sèment également les graines de futures rivalités et poussent les acteurs à une diversification stratégique pour ne pas être pris en otage.

Le Verdict du Marché et le Défi de la Valeur

Le comportement du marché boursier offre un reflet saisissant de cette réalité où le capital favorise l’infrastructure au détriment de l’applicatif. Les investisseurs plébiscitent sans la moindre hésitation ceux que l’on pourrait qualifier de « vendeurs de pioches et de pelles » de la ruée vers l’or de l’IA. Les fabricants de semi-conducteurs et de matériel spécialisé voient leurs valorisations boursières atteindre des niveaux spectaculaires, avec une croissance impressionnante depuis le début de l’année dernière. Cette tendance s’explique par une certitude simple : quelle que soit l’application d’IA qui finira par dominer le marché, toutes, sans exception, auront besoin de la puissance de calcul phénoménale fournie par ce matériel. Leur position stratégique au début de la chaîne de valeur leur garantit une demande quasi insatiable, directement alimentée par les milliards de dollars investis par tous les autres acteurs de l’écosystème. Ils sont perçus comme les bénéficiaires inévitables et les moins risqués de cette révolution technologique en cours.

En revanche, le secteur des logiciels et des services a subi une correction sévère, traduisant une profonde anxiété de la part des investisseurs. La crainte prédominante est que la nouvelle génération d’IA ne se contente pas d’améliorer les outils existants, mais qu’elle les rende purement et simplement obsolètes. Des pans entiers de logiciels de productivité, d’outils professionnels et de services pourraient être réduits à de simples fonctionnalités, facilement remplaçables par des agents d’IA plus performants et intégrés. Cette sanction boursière n’était pas une simple fluctuation, mais le reflet d’une menace existentielle qui a forcé les entreprises de logiciels à redéfinir leur proposition de valeur. Pour survivre et défendre leurs valorisations, elles ont dû prouver qu’elles n’étaient pas de simples « couches de productivité » interchangeables. Leur salut a résidé dans leur capacité à se positionner comme des « systèmes d’enregistrement » indispensables, détenant des données propriétaires uniques et inimitables. La stratégie a consisté à intégrer l’IA au plus profond des flux de travail de leurs clients, à verrouiller l’accès à des données exclusives et à démontrer que leur véritable valeur se trouvait dans cet actif informationnel que l’IA seule ne pouvait répliquer.