Alors que les entreprises adoptent massivement l’intelligence artificielle agentielle pour automatiser des tâches complexes et optimiser leurs opérations, une nouvelle surface d’attaque, à la fois subtile et puissante, émerge discrètement au sein de leurs infrastructures informatiques. Ces agents autonomes, conçus pour interagir avec des systèmes et d’autres agents, promettent une efficacité sans précédent, mais leur déploiement rapide et souvent non maîtrisé crée des brèches de sécurité critiques qui pourraient bien devenir le talon d’Achille des organisations modernes. La capacité de ces entités numériques à prendre des décisions et à exécuter des actions de manière indépendante introduit un niveau de risque inédit, transformant des outils de productivité en potentiels vecteurs de cyberattaques sophistiquées. Les experts en cybersécurité tirent la sonnette d’alarme, soulignant que la course à l’innovation a laissé la sécurité au second plan, ouvrant la voie à des menaces d’un genre nouveau où les pirates n’exploitent plus seulement du code, mais manipulent des intelligences artificielles pour atteindre leurs objectifs.

1. La Menace Insidieuse du Mouvement Latéral

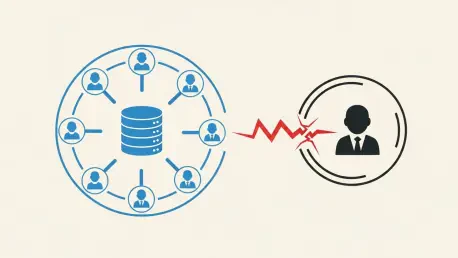

Le concept de mouvement latéral, bien connu dans le domaine de la cybersécurité, prend une dimension particulièrement alarmante avec l’avènement des agents IA. Cette technique permet à un attaquant, après avoir compromis un point d’entrée initial, de se déplacer à travers le réseau d’une organisation pour accéder à des actifs de plus grande valeur. Dans le contexte de l’IA agentielle, ce processus est à la fois simplifié et amplifié. Un cybercriminel peut d’abord prendre le contrôle d’un agent aux privilèges limités, par exemple un agent conçu pour trier des courriels. En exploitant les interconnexions entre agents, il peut ensuite utiliser cette première brèche pour communiquer avec un second agent plus puissant, comme celui ayant accès à la base de données clients ou aux systèmes financiers. Chaque agent compromis devient alors un maillon d’une chaîne d’attaque, permettant une élévation progressive des privilèges. Cette méthode est d’autant plus dangereuse que les interactions entre agents peuvent sembler légitimes pour les systèmes de surveillance traditionnels, rendant la détection extrêmement complexe.

Cette vulnérabilité systémique trouve en partie sa source dans la nouveauté même de la technologie. Le développement de plateformes d’IA agentielle s’est jusqu’à présent concentré sur la fonctionnalité et l’interopérabilité, reléguant souvent les considérations de sécurité à une étape ultérieure. Cette situation rappelle les débuts du développement logiciel, où les programmeurs, faute de connaissances et de standards établis en matière de sécurité, créaient sans le savoir des applications truffées de failles béantes. Aujourd’hui, l’histoire semble se répéter. Les développeurs d’agents IA, poussés par la demande du marché, n’ont pas encore pleinement anticipé toutes les manières dont leurs créations pourraient être détournées. La complexité des interactions autonomes entre des dizaines, voire des centaines d’agents, crée un écosystème où une seule mauvaise configuration ou une API mal sécurisée peut avoir des conséquences en cascade, transformant l’ensemble du parc agentique d’une entreprise en un terrain de jeu pour les attaquants.

2. L’Émergence des Agents Fantômes et des Vulnérabilités Concrètes

Le risque est encore aggravé par un phénomène que les experts de Google ont baptisé les « agents fantômes » (shadow agents). Ce terme désigne la prolifération d’agents IA puissants et autonomes que les employés déploient de leur propre initiative, sans l’approbation ou la supervision du département informatique. Motivés par la recherche de productivité, les collaborateurs peuvent connecter ces agents à des sources de données sensibles de l’entreprise, créant ainsi des canaux invisibles et non contrôlés pour des informations critiques. Ces déploiements parallèles, en dehors de toute politique de sécurité, augmentent de manière exponentielle la surface d’attaque. Chaque agent fantôme représente une porte dérobée potentielle, échappant aux radars de sécurité et pouvant entraîner des fuites de données massives, des violations de conformité réglementaire et des vols de propriété intellectuelle. Le problème de la « shadow IT » , déjà bien connu des DSI, est ainsi projeté dans une nouvelle dimension avec l’autonomie et la capacité d’action de l’IA.

Deux cas récents, impliquant des géants de la technologie, illustrent de manière frappante la réalité de ces menaces. Des chercheurs ont découvert une faille critique sur la plateforme ServiceNow, nommée « BodySnatcher » . Cette vulnérabilité permettait à un pirate non authentifié d’usurper l’identité d’un administrateur en utilisant simplement une adresse électronique. Une fois cette identité compromise, l’attaquant pouvait ordonner à un agent IA de créer des comptes administrateurs cachés, lui octroyant ainsi des privilèges complets et un accès quasi illimité aux données les plus sensibles de l’organisation, telles que les dossiers médicaux ou la propriété intellectuelle. ServiceNow a rapidement réagi en publiant un correctif en octobre 2025, affirmant n’avoir eu connaissance d’aucune exploitation malveillante. Ce cas démontre cependant à quel point une seule faille dans la gestion des identités des agents peut compromettre l’intégralité d’un système.

3. Des Configurations par Défaut qui Posent Problème

Chez Microsoft, une autre problématique a été mise en lumière par les chercheurs de Zenity Labs. Au sein de Copilot Studio, une fonctionnalité baptisée « Connected Agents » est activée par défaut lors de la création d’un nouvel agent. Cette option permet aux agents de communiquer entre eux, une caractéristique essentielle pour l’interopérabilité et la collaboration entre systèmes automatisés. Cependant, cette configuration par défaut crée également un risque majeur. Elle peut être détournée par des acteurs malveillants pour établir des connexions latérales entre un agent compromis et des agents légitimes, exploitant ainsi les accès de ces derniers pour exfiltrer des courriels, des documents confidentiels ou d’autres données commerciales sensibles. Le fait que cette fonctionnalité soit activée sans action explicite de l’administrateur contredit les principes fondamentaux de la sécurité, notamment celui du « Secure by Default » prôné par Microsoft lui-même dans son initiative Secure Future.

Face à ces observations, la position de Microsoft est que « Connected Agents » n’est pas une vulnérabilité, mais une fonctionnalité inhérente au bon fonctionnement de l’écosystème. L’entreprise recommande aux administrateurs de désactiver manuellement cette option pour les agents qui manipulent des données sensibles. Cette approche transfère cependant la responsabilité de la sécurité sur les utilisateurs et les administrateurs, qui doivent être conscients du risque et agir de manière proactive pour le mitiger. Cela soulève une question fondamentale : dans un environnement technologique de plus en plus complexe, la sécurité ne devrait-elle pas être la norme plutôt qu’une option à configurer ? La pression pour la rentabilité et la mise sur le marché rapide de nouvelles fonctionnalités semble parfois prendre le pas sur une conception sécurisée dès l’origine, un compromis qui pourrait s’avérer coûteux à long terme, comme le prévoit Gartner qui estime que 25 % du travail informatique sera effectué par l’IA seule d’ici 2030.

Une Vigilance Devenue Impérative

Face à ces défis, l’adoption systématique d’une posture de « privilège minimal » est devenue la recommandation unanime des experts en cybersécurité. Ce principe fondamental consistait à s’assurer que chaque agent IA ne dispose, par défaut, que des autorisations strictement nécessaires à l’accomplissement de sa tâche spécifique, et rien de plus. L’approche exigeait de commencer par un accès quasi nul dans tout environnement d’exécution, puis d’ajouter méticuleusement chaque privilège requis. Il était également devenu crucial de tracer et de surveiller chaque interaction entre les agents, car la surveillance des conversations entre entités autonomes représentait un défi technique majeur. Des outils comme Entra Agent ID de Microsoft fournissaient une identité à chaque agent, mais la génération d’alertes automatiques pour des exploitations inter-agents restait une étape à perfectionner. L’effort collectif de l’industrie, incluant des acteurs majeurs comme Okta, Ping Identity et Cisco, a permis de proposer des solutions et des cadres de gouvernance pour maîtriser cette expansion et empêcher les agents malveillants d’infiltrer les réseaux.